Dusty Rooms: uno sguardo al MSX

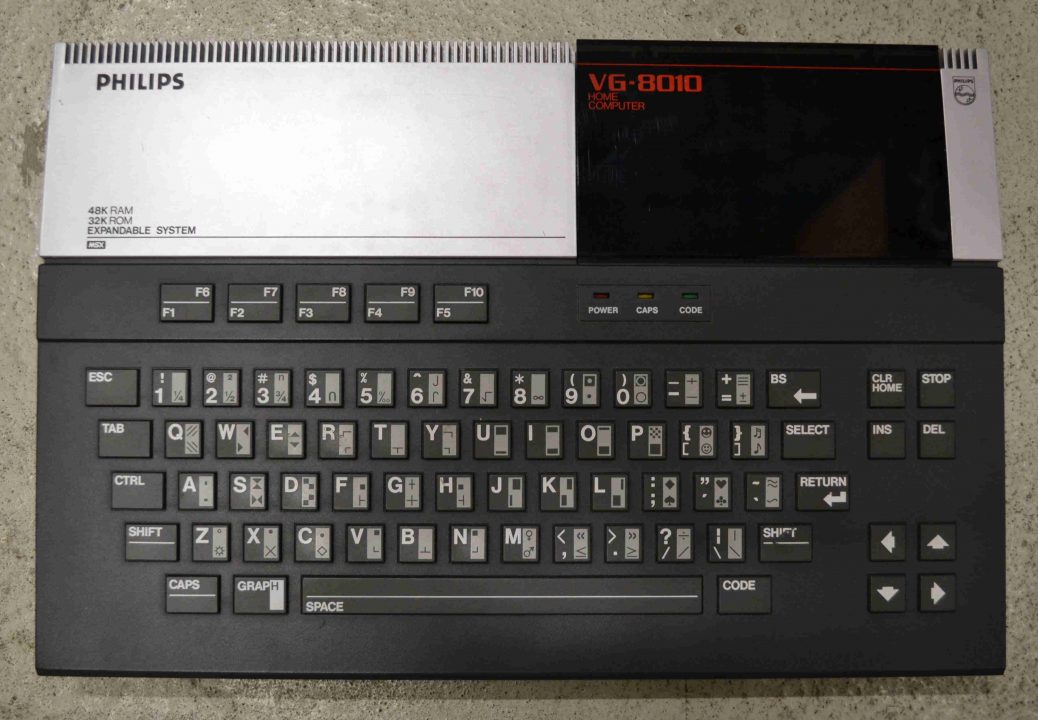

L’obiettivo di questa rubrica è principalmente quello di far scoprire quelle parti di retrogaming curiose, interessanti e, possibilmente, non ancora prese in esame. Oggi, qui a Dusty Rooms, daremo uno sguardo ai computer MSX, un sistema ancora non comune e che forse non lo sarà mai, probabilmente per via della sua scheda madre, un prodotto da vendere su licenza a terze parti affinché la producessero con i loro mezzi. Certo, il Commodore 64, l’Amstrad, l’Apple II e i computer Atari sono stati sicuramente i più popolari negli anni ’80 ma se oggi lo scenario dei personal computer è come lo conosciamo, lo si deve principalmente a queste favolose macchine MSX che finirono per dettare degli standard in quanto a formati e reperibilità dei software. Per capire l’innovazione portata da questi computer, utili sia per il gaming che per la programmazione, bisogna dare uno sguardo allo scenario tecnologico di quegli anni.

Non fare il Salame! Compra un computer!

Negli anni ’80 i computer cominciarono a far parte della vita di milioni di persone e, sia in termini di costi che di dimensioni, erano decisamente alla portata di tutti; in Nord America si assistette a un’impennata per via del crollo del mercato dei videogiochi del 1983, in quanto i genitori erano più propensi a comprare un PC per i loro figli con la quale poter sia giocare che studiare, e in Europa, e molte altre parti del mondo, avevano preso piede ancor prima delle console rudimentali come Atari 2600, Philips Videopac (Magnavox Odyssey 2 in Nord America) o il Coleco Vision. Tuttavia, in negozio, scegliere un computer rispetto a un altro era un impresa tutt’altro che facile: ogni macchina era in grado di leggere videogiochi e eseguire programmi gestionali, creativi o educativi ma, ogni compagnia, proponeva il proprio sistema e linguaggio di programmazione e perciò, senza uno standard, la compatibilità fra le macchine era pressoché nulla; il tutto era aggravato inoltre dalle centinaia di pubblicità che proponevano sempre il loro computer come il più veloce e generalmente migliore rispetto alla concorrenza. Lo scenario era ben diverso da quello odierno in cui sono presenti principalmente due sistemi operativi dominanti e, indipendentemente dal modello fisico che si prende in esame, è molto più facile orientarsi in un mercato che dà meno alternative e in cui la compatibilità è sempre più ampia.

(Pensate, compravate un Commodore 64 per la vostra azienda ma poi, una volta a casa, accendevate la TV e c’era Massimo Lopez che vi proponeva il suo migliore computer SAG e voi entravate in paranoia!)

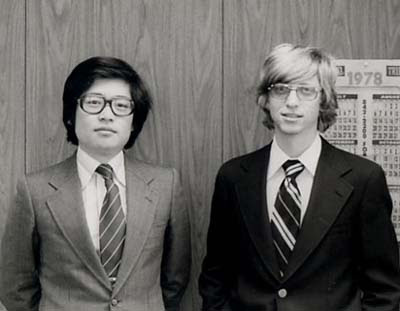

Negli anni ’70 un giovane Kazuhiko Nishi, studente dell’Università di Waseda, cominciava a interessarsi al mondo dei computer, software ed elettronica con il sogno di costruire una console con i propri giochi e poterla rivendere ma, dopo una visita alla fabbrica della General Instruments, capì che non poteva comprare dei chip in piccole quantità per poter sperimentare e perciò dovette rinunciare momentaneamente al suo sogno. Cominciò a scrivere per alcune riviste d’elettronica affinché potesse mettere a disposizione la sua conoscenza per la programmazione ma, se voleva trarne il massimo vantaggio da questa attività, doveva necessariamente fondare una sua compagnia e fare delle sue pubblicazioni. Dopo aver lasciato l’università, Nishi fondò la ASCII per poter pubblicare la sua nuova rivista I/O, che trattava di computer, ma nel 1979 la pubblicazione cambiò nome in ASCII magazine che si interessava più generalmente di ogni campo dell’elettronica, inclusi i videogiochi. Con il successo della rivista Kazuhiko Nishi poté tornare al suo progetto originale, ovvero creare una macchina tutta sua, ma per farlo aveva bisogno di un linguaggio di programmazione; egli contattò gli uffici Microsoft riuscendo a parlare, con la prima telefonata, con Bill Gates e più tardi, quello stesso anno, riuscirono a incontrarsi. Entrambi avevano la stessa passione per l’elettronica, più o meno lo stesso background sociale (entrambi avevano lasciato gli studi accademici) e dopo diversi meeting aderirono per fare del business assieme. ASCII diventò la rappresentante di Microsoft in Giappone e Kazuhiko Nishi divenne vicepresidente della divisione giapponese della compagnia americana. Grazie a questa collaborazione Nishi poté inserire il BASIC nel PC 8000 di Nec, la prima volta che veniva incluso all’interno di un computer, ma nel 1982, quando Harry Fox e Alex Weiss raggiunsero Microsoft per poter creare dei software per il loro nuovo computer chiamato Spectravideo, egli vide le basi per coniare il suo progetto iniziale e cominciare a produrre una linea di PC compatibili fra loro visto che la macchina era costruita intorno allo Zilog Z80, un processore che faceva da punto in comune fra diversi computer e persino console (essendo incluso nel Coleco Vision, console che, prima dell’avvento del NES, andava molto forte). Kazuhiko Nishi voleva che il suo computer fosse piccolo, come quelli che aveva prodotto alcuni anni prima per Kyocera, doveva contenere almeno uno slot per delle cartucce ROM, essere facilmente trasportabile ed espandibile e doveva contenere una versione di BASIC migliore dei computer IBM; così composto era la sua perfetta visione di computer in grado di poter garantire uno standard fra queste macchine. Poco dopo Nishi contattò tutte le più grandi compagnie giapponesi come Casio, Mitsubishi, Fujitsu, Kyocera, Sony, Samsung e Philips, rispettivamente, che decisero di investire in questo nuovo progetto; fu così che nacque lo standard MSX.

(Kazuhiko Nishi e Bill Gates)

Software per tutti!

Come abbiamo già detto, le macchine MSX nascono dall’unione di ASCII e Microsoft nel tentativo di fornire uno standard per i manufattori di PC. Era parere comune, ai tempi, che “MSX” stesse per “MicroSoft eXtended” ma Kazuhiko Nishi, più tardi, smentì queste voci dicendo che la sigla stava per “Machine with Software eXchangeability“. Con questo nuovo standard, tutti i computer che esponevano il marchio MSX erano dunque compatibili fra loro; perciò, cosa rendeva un’unità uguale a un’altra? Per prima cosa la CPU 8-bit Zilog Z80A, chip creato dall’italiano Federico Faggini e che ne costituisce il cervello della macchina, poi abbiamo la VDP (Video Display Processor) TMS9918 della Texas Instrument che offre una risoluzione di 256 x 192, 16 colori per sprite di 32 pixel, il chip sonoro AI36910 della Yamaha che offre tre canali e tre ottave di tonalità e infine la ROM di 32kb contenente il BASIC di Microsoft; il computer è comprensivo di tastiera ed è possibile attaccare mangianastri, strumento essenziale per i computer dell’epoca, lettore floppy, almeno una porta per i joypad e ha anche una porta d’espansione. Tipico di molti MSX era un secondo slot per le cartucce che, inserendone una seconda, permetteva miglioramenti, cheat e persino espansioni per un determinato software (dopo vi faremo un esempio). Per via delle diverse aziende che producevano i computer MSX è difficile arrivare a un numero preciso di computer venduti nel mondo ma, per darvi un idea, nel solo Giappone sono stati venduti ben cinque milioni di computer, praticamente la migliore macchina da gaming prima dell’arrivo del Famicom. Le macchine ebbero successo anche in altri paesi come Olanda, Spagna, Brasile, Corea del Sud, Arabia Saudita e persino in Italia e Unione Sovietica. Al fine di proporre una macchina sempre più potente, ci furono ben altre quattro generazioni di MSX: MSX2, rilasciato nel 1985, MSX2+, nel 1988, e MSX TurboR nel 1990. La differenza nelle prime tre stava nel nuovo processore Z80 che poteva permettere molti più colori su schermo e una velocità di calcolo maggiore, mentre l’ultimo modello presentava un processore 16-bit R800 ma purtroppo, essendo a quel punto rimasta solamente Panasonic a produrre gli MSX, non fu supportato a lungo. Come abbiamo accennato, i computer MSX erano le macchine dominanti per i videogiochi casalinghi in Giappone, anche se per poco tempo visto che il Famicom arrivò poco dopo, lo stesso anno; tuttavia, nonostante il dominio generale della console Nintendo, il sistema fu supportato fino all’ultimo e tante compagnie, come Hudson Soft e Compile, sfruttarono ogni capacità di questa curiosa macchina; l’eccezione va fatta per Konami che, nel 1983, fondò un team dedicato per produrre giochi su MSX, un anno prima di firmare per Nintendo. Finita la festa, nel 2001 Kazuhiko Nishi ha annunciato il revival del MSX rilasciando liberamente l’emulatore MSXPLAYer, dunque, eticamente, siamo liberi di goderci questi giochi sul nostro PC (anche perché il Project EGG, una piattaforma simil Steam per i giochi per computer giapponesi, qui non c’è); tuttavia, nulla vieta di recuperare l’hardware originale anche se dovete tener conto dell’alto prezzo dei giochi; un’ultima buona alternativa è recuperare la Konami Antiques MSX Collection per Sony PlayStation e Sega Saturn che vi permetterà di giocare a molti titoli (la versione per la prima è divisa in quattro dischi mentre la seconda include tutti i giochi). Diamo uno sguardo a 10 giochi essenziali di questa macchina (ci scusiamo in anticipo se la maggior parte dei giochi saranno Konami!).

10. King’s Valley 2

Un platformer che unisce elementi puzzle alla Lode Runner. Per procedere ai livelli successivi servirà collezionare tutte le pietre dell’anima sparse negli stage utilizzando i vari strumenti presenti, cui potremmo utilizzarne solo uno per volta. Man mano che si procede, gli scenari diventeranno sempre più grandi e difficili perciò non bisogna prendere questo gioco sottogamba. Una feature interessante, molto avanti per i suoi tempi, era l’editor dei livelli: una volta completati si potevano salvare in un floppy e scambiarli con gli amici.

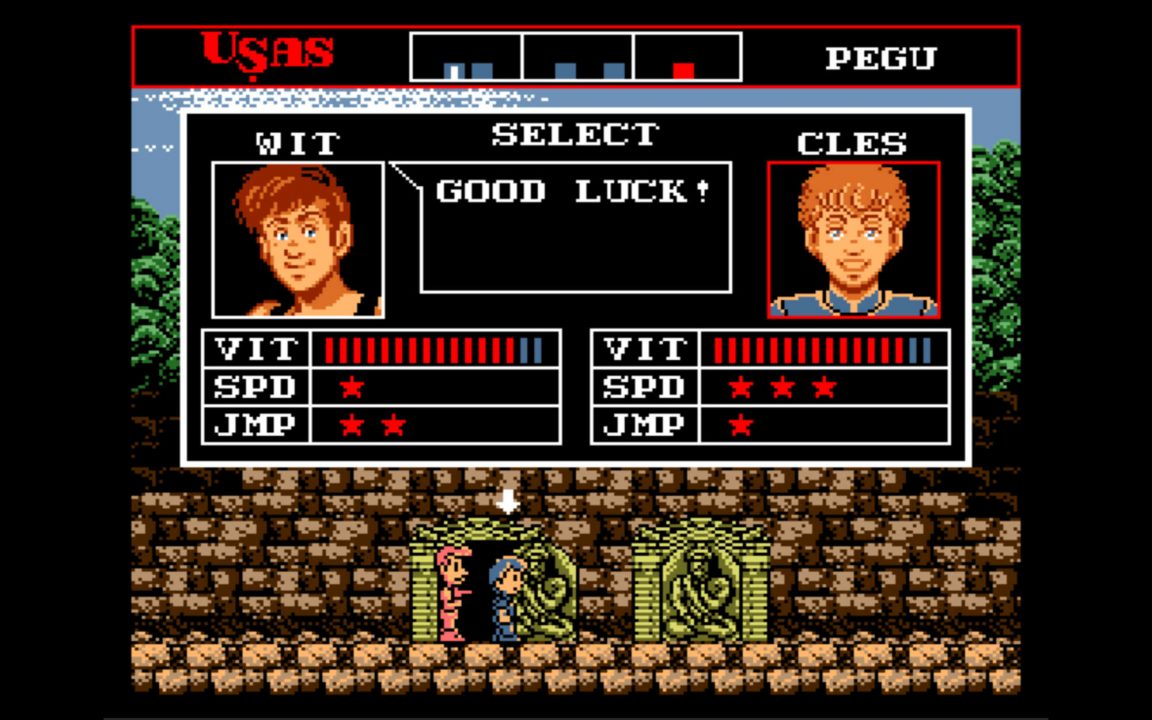

9. Treasure of Usas

Un action platformer poco conosciuto ma comunque molto curioso che potrebbe interessare molto ai fan di Uncharted e Tomb Raider. Wit e Cles sono due cacciatori alla ricerca del tesoro di Usas e dovranno attraversare cinque città antiche per poterlo ritrovare. Il primo ha una pistola e migliori abilità nel salto mentre il secondo è un maestro di arti marziali e più agile. Le loro abilità sono migliorabili collezionando le monete negli stage e il gioco presenta la curiosa meccanica degli umori: nello stage infatti, sono sparse le cosiddette carte dell’umore che, una volta raccolte, cambieranno i nostri attacchi. Una vera chicca se siete amanti di Castlevania o Mega Man.

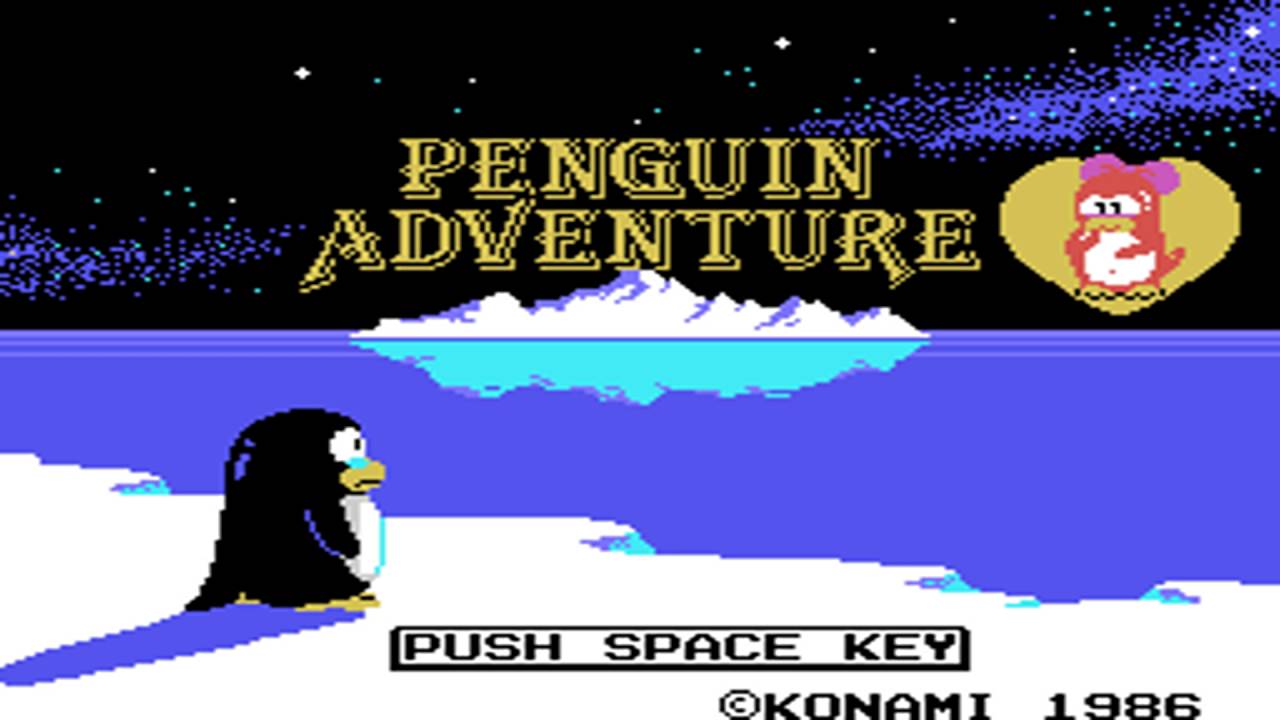

8. Penguin Adventure

A Hideo Kojima game… ebbene si! Prima di Snake e i loschi tipi di Death Stranding (di cui non sappiamo ancora nulla) il noto programmatore ha prodotto questo gioco “puccioso” in cui dobbiamo far riunire Pentaro alla sua amata principessa. Nonostante il gioco abbia una struttura arcade apparentemente semplice, ovvero una sorta di platformer automatico simil 3D (oggi potremmo definirlo un runner per smarphone), questo gioco ha molte meccaniche intriganti come un in-game store, warp zone, tanti easter egg e persino un finale alternativo. Mai giudicare un libro dalla sua copertina!

7. King Kong 2

Essendo liberamente ispirato al film King Kong Lives (o King Kong 2), controlleremo Hank Mitchell alla ricerca di Lady Kong. Raccomandiamo questo titolo ai fan del primo The Legend of Zelda in quanto molto simile e con tante caratteristiche interessanti che lo rendono davvero un bel gioco. Siate sicuri di trovare la rom “patchata” poiché non è mai stato rilasciato in Europa.

6. Vampire Killer

Sembrerebbe un porting per MSX2 di Castlevania per NES ma così non è; sebbene il gioco abbia più o meno la stessa grafica, esso presenta un gameplay totalmente diverso. Questo titolo, anziché concentrarsi nelle sezioni di platforming, è più basato sull’esplorazione e il puzzle solving: per avanzare bisognerà trovare la skeleton key e per farlo ci serviranno armi, oggetti e chiavi per aprire forzieri contenti power up che si riveleranno utili allo scopo. Il gioco ha un pacing ben diverso dall’originale per NES ed è raccomandato ai giocatori più pazienti (anche perché le vite sono limitate e mancano i continue) ma anche ai più accaniti fan della saga.

5. Aleste

Unico gioco non Konami di questa lista, è uno shoot ‘em up sensazionale di Compile; uscito originariamente per Sega Master System, questa versione presenta due stage extra e una difficoltà più abbordabile. Di questo gioco stupiscono principalmente la grafica, la strabiliante colonna sonora resa con un chip FM montato sulla cartuccia e l’azione velocissima (tipica della serie) che da vita a battaglie in volo spettacolari. Provare per credere!

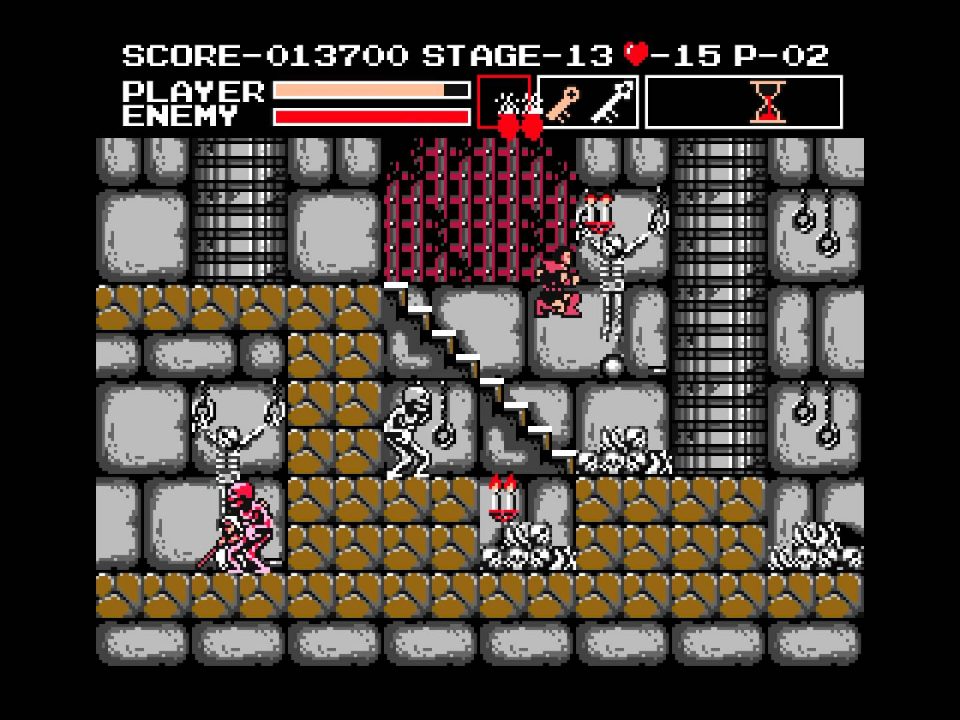

4. The Maze of Galious – Knightmare II

Concepito originariamente per competere con Zelda II: The Adventure of Link, The Maze of Galious è un difficilissimo metroidvania per i più allenati. In questo popolarissimo titolo per MSX, bisognerà esplorare un castello immenso alla ricerca delle dieci sub aree, dove risiedono demoni da sconfiggere, ma anche degli oggetti sparsi nel castello che espanderanno le abilità dei nostri Popolon e Aphrodite. The Maze of Galious è il secondo titolo della saga Knightmare, il cui primo titolo era un top down shooter alla Ikari Warriors e il terzo un RPG (per MSX2), ed è certamente il più bello. Nel 2002, questo titolo è stato soggetto di un curioso remake non ufficiale e il suo acclamato gameplay è stato ripreso nel similissmo La Mulana, considerato il suo sequel spirituale. Se siete fan dei metroidvania questo è certamente un titolo da giocare, anche per coloro che apprezzano le vere fide come Ghosts ‘n Ghouls, il già citato Zelda II o, chissà, magari anche Dark Souls! Vi raccomandiamo di giocarci con un walkthrough o almeno una mappa del castello; se siete dei masochisti fate pure senza!

3. Nemesis 2 e 3 + Salamander

Un pari abbastanza assurdo ma vi assicuriamo che non c’era modo per rendere giustizia a questi tre spettacolari titoli. I primi due sono dei sequel di Gradius mentre il Salamander proposto su MSX è completamente diverso dalla controparte per NES. Questi titoli della saga di Gradius su MSX presentano, insieme a delle colonne sonore squisite espresse con l’esclusivo chip SCC, un gameplay profondissimo attraverso power up espandibili, oggetti e sezioni bonus nascosti nei livelli e lo storytelling più dettagliato della saga. In Salamander, inoltre, per ottenere il finale migliore bisognerà inserire la cartuccia di Nemesis 2 nel secondo slot per completare il vero livello finale e mettere fine alla minaccia dei bacterion; altro che DLC e Amiibo! Nemesis 2 e Salamander sono i titoli più difficile mentre Nemesis 3: The Eve of Destruction è il più accessibile, perciò, se volete provarli, vi consigliamo di partire da lì. Tuttavia, dovrete abituarvi allo scrolling “scattoso” di questi titoli in quanto gli MSX, prima della seconda generazione, non erano in grado di offrire un’azione fluida e senza problemi;

2. Metal Gear e Metal Gear 2: Solid Snake

È più che risaputo che la saga di Metal Gear ha origini nel MSX2 e che quelli per NES non sono i veri punti iniziali della saga (per Snake’s Revenge, sequel non canonico del primo titolo, Hideo Kojima non era neppure stato chiamato per lo sviluppo del gioco). Entrambi i Metal Gear, soprattutto il secondo, sono dei giochi incredibili per essere dei giochi in 8-bit e, nonostante in molti ignorino questi due titoli, sono fondamentali per la fruizione dell’intera saga. Molte degli elementi visti in Metal Gear Solid come le chiavi sensibili alla temperatura, l’assalto all’interno dell’ascensore, l’abbattere l’Hind-D con i missili stinger e lo sgattaiolare nei condotti d’aria erano già stati introdotti in Metal Gear 2: Solid Snake; altri due titoli immancabili per MSX e giocabili persino in Metal Gear Solid 3: Subsistence. Non avete scuse per non giocarli!

1. Space Manbow

Questa rubrica si chiama Dusty Rooms e, pertanto, lo scopo è quello di farvi riscoprire titoli dimenticati e particolarmente interesanti; considerate quest’ultima entrata come un nostro personale regalo. Space Manbow è uno shoot ‘em up strabiliante pieno d’azione e retto da una grafica dettagliatissima per essere un gioco 8-bit, una colonna sonora spettacolare resa col chip SCC e un gameplay vario e mozzafiato, reso ancora più intrigante grazie allo scrolling fluido del MSX2 (cosa di cui i titoli di Gradius non poterono godere). Nonostante le lodi di critica e fan, Space Manbow rimane, a tutt’oggi, relegato a MSX e Konami, al di là di qualche cameo in qualche altro titolo, non ha mai preso in considerazione l’idea di un sequel (anche se ne esiste uno non ufficiale fatto dai fan uscito tanti anni dopo su MSX2), né allora né tanto meno adesso. Diamo a questo capolavoro l’attenzione che merita!

Honorable mentions

Che dire? Dieci posizioni sono veramente poche per una console che ha dato così tanto ma qui, vi vogliamo dare un altro paio di titoli da rivisitare su MSX:

- Snatcher & SD Snatcher: altri due titoli di Hideo Kojima. Il primo è una visual novel mentre l’altro ricalca la stessa storia ma in veste RPG. Recuperate il secondo su MSX2 ma giocate Snatcher altrove in quanto la versione per MSX è incompleta e inconcludente.

- Xevious: Fardraut Saga: da un semplice coin-op per arcade a uno SHMUP moderno con trama ed espansioni varie. Un titolo decisamente da recuperare!

- Eggerland 2: il secondo gioco della saga di Lolo e Lala. Un puzzle game da capogiro per riscoprire le origini dello studio Hal.

- Ys (I, II & III): una delle saghe RPG più strane e sottovalutate di sempre. Giocare questi titoli su MSX non è raccomandabile per via della barriera linguistica ma il loro aspetto su questo computer è decisamente sensazionale.

- Quarth: un puzzle game Konami molto interessante che metterà alla prova il vostro ingegno. Un’altro bel gioco da recuperare